როგორც ჩანს, Apple-მა დაივიწყა iPhone-ზე აკრძალული ფოტოების სკანირების ფუნქცია

გაზიარება:

დაკავშირებული პოსტები

AI

Apple გეგმავს Private Cloud Compute-ის არქიტექტურის განახლებას უახლესი M5 ჩიპებით

AI

Apple განიხილავს Mistral-ისა და Perplexity-ის შეძენას

Apple

Apple-მა iPhone 7 Plus და iPhone 8 სმარტფონები მოძველებული მოწყობილობების სიაში დაამატა

Apple

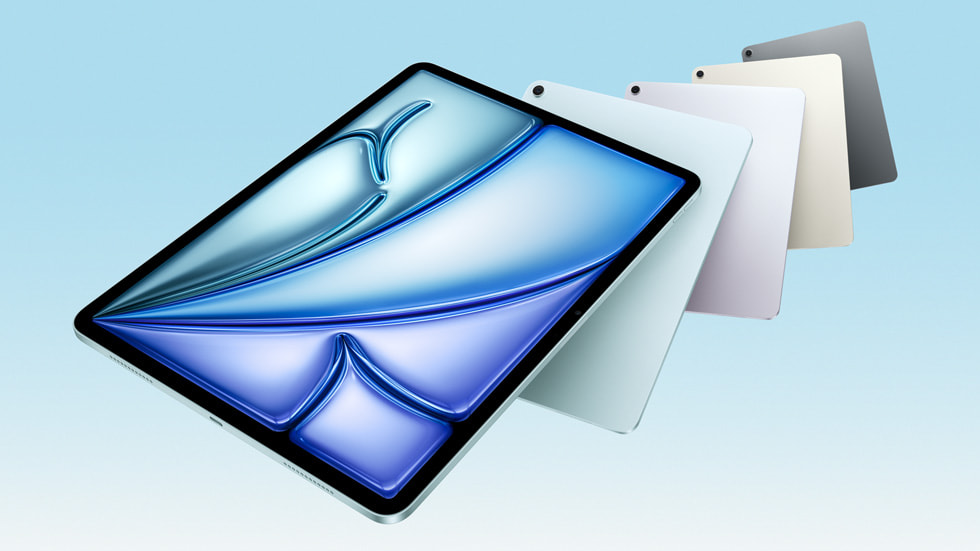

Apple-მა წარმოადგინა iPad Air M3 ჩიპით და საბაზისო iPad A16 ჩიპით

Apple

Apple 500 მილიარდ დოლარზე მეტ ინვესტიციას განახორციელებს აშშ-ში წარმოების გაფართოებისთვის და შექმნის 20 ათას ახალ სამუშაო ადგილს

Apple